- Credo

- Wer wir sind

- Aktuelles

- Wissenschaft & Philosophie

- Informationen

- Veranstaltungen

- Projekte

- Blog

- Mitgliedschaft

- Spenden

- Kontakt

Quanten-Idealismus und Simulations-Hypothese

Ein kurzer Abriss und Ausblick, einschließlich der Implikationen für Theismus und Intelligentes Design

Version 1, 28. November 2019

(aktualisierte Version 54, 31. Oktober 2022)

Quanten-Idealismus ist eine idealistisch-monistische Metaphysik auf der Grundlage moderner Erkenntnisse im Bereich der Digitalen Physik. Diese deuten auf unmittelbare Zusammenhänge zwischen physikalischer Realität und virtuellen Realitäten hin. Dazu zählen nicht nur allgemein bekannte Phänomene der Relativitätstheorie und Quantenphysik, sondern auch die noch weniger bekannte Forschung im Bereich der Quantengravitation, die zunehmend darauf hinweist, dass Raumzeit kein fundamentales, sondern ein emergentes Phänomen ist. Zudem sieht eine zunehmende Zahl von Physikern Information als Grundlage allen Seins (Lloyd 2006, Seife 2006, Vedral 2010, Davies & Gregersen 2014, Ananthaswamy 2017, Glattfelder 2019), einschließlich der Konstruktor Theorie von Deutsch & Marletto (2014). Kombiniert man diese Erkenntnisse der modernen Physik mit den modernen Erkenntnissen aus der Bewusstseins- und Hirnforschung (Hoffmans Bewusstseins-Realismus, Tononis Theorie der Integrierten Information, Quanten-Kognition, Quantenbiologie des Gehirns und Quantentheorie des Bewusstseins), so gelangt man zu dem Ergebnis, dass die physikalische Realität nur ein Informationskonstrukt innerhalb eines universellen Bewusstseins ist. Dies hat wichtige Implikationen sowohl für die Frage nach Teleologie und Design in der Natur als auch für die Theologie.

Die Hinweise der modernen Physik auf eine monistisch-idealistische und neo-platonistische Metaphysik mit Bewusstsein und/oder Information als Grundlage wurden von zahlreichen Physikern erkannt, von den frühen Vätern der Quantenmechanik (Neumann 1955, Wigner 1961), über Carl Friedrich von Weizäckers (1985) „Quantentheorie der Ur-Alternativen“, John Archibald Wheelers (1989) „It from Bit“, bis hin zu Seth Lloyds (2013) Ansicht des Universums als Quantencomputer und Max Tegmarks (2016) Hypothese vom „Mathematischen Universum“ (siehe auch Heinrich 2012). Andere moderne Denker kamen auf unterschiedlichem Weg zu sehr ähnlichen Ansichten (Teilhard de Chardin 1955, Zuse 1967, 1969, Bass 1971, Sprigge 1984a, Mohanty 1989, Goswami 1989, 1993, 1995, 2001 Squires 1990, Driessen & Suarez 1997, Hutto 2000, Wolfram 2002, Svozil 2005, Zizzi 2006, Monton 2000, 2009, Campbell 2007, Blood 2009a, Leslie 2001, Popov 2003, Conn Henry 2005, Lanza 2009, Stapp 2011, Li 2013, Schmidhuber 2013, Hameroff & Penrose 2014, Hettema 2015, Zahedi 2015, Haynes 2016, Pearce 2017, Gordon 2017, Lokanga 2018, Chalmers 2019, Kastrup 2019a, 2019b, Virk 2019, Vikoulov 2019, Yeates 2019, Bandyopadhyay 2020, Irwin et al. 2020). Eine zunehmende Anzahl naturalistischer Denker ist zudem zu der Auffassung gelangt, dass das "harte Problem" (sensu Chalmers) des Bewusstseins überhaupt nur dann physikalistisch lösbar sein könnte, wenn der Materialismus zu Gunsten eines Panpsychismus aufgegeben wird (Strawson 2009, Seager 2014, Pearce 2017). Die derzeit deshalb populärer werdende Philosophie des Panexperientiellen Holismus bzw. Kosmopsychismus (Dyson 1988, Jaskolla & Buck 2012, Shani 2015, Nagasawa & Wagner 2016, Shani & Keppler 2018, Goff 2017, 2019a, 2019b) bejaht ebenfalls die Existenz eines universellen Bewusstseins, jedoch noch unter Beibehaltung einer materiellen Realität durch einen panpsychistischen Eigenschaftsdualismus. Argumente gegen einen solchen Kosmopsychismus und zu Gunsten eines universellen Bewusstseins im Sinne des monistischen Idealismus wurden u.a. von Albahari (2019) formuliert. Mögliche Einwände gegen eine idealistische Metaphysik wurden von Bernardo Kastrup (2019a, 2019b) umfassend diskutiert und entkräftet.

Wichtige Argumente kommen aus der Simulations-Theorie (Bostrom 2003), deren Vertreter behaupten, dass unsere Welt mit großer Wahrscheinlichkeit eine Computer-Simulation sei. Dies stößt natürlich auf das Problem eines unendlichen Regresses, da sich mit dieser Argumentation eine endlose Anzahl verschachtelter Simulationen innerhalb von Simulationen ergibt. Die Annahme, dass die „Simulation“ der Welt statt in einem Computer in einem universellen Bewusstsein erfolgt, ist demgegenüber deutlich sparsamer und erklärt zudem auch die Natur der Basis-Realität. Zudem gibt es auch theoretische Einwände gegen die Machbarkeit einer Simulation der physikalischen Realität in einem Computer (Rucker 2008, 2012). Die Hypothese, dass die Welt nur eine Simulation in einem universellen Bewusstsein ist, hat es inzwischen sogar in den Mainstream geschafft, wie dieses Interview mit dem Physiker Michio Kaku beim TV-Sender Fox zeigt.

Für die weiteren Ausführungen ist zunächst eine Begriffsbestimmung notwendig:

- Objektiv reale Welten sind Welten die unabhängig vom Beobachter existieren und keiner externen Erklärungen bedürfen.

- Virtuelle Realitäten beruhen auf Informationsverarbeitung außerhalb der Welt selbst.

Die Simulations-Theorie beruft sich auf empirische Hinweise, dass unsere physikalische Realität eher eine virtuelle als eine objektiv reale Welt ist. In dieser sehr allgemeinen Formulierung ist zunächst einmal irrelevant, ob die Simulation in einem materiellen Computer oder in einem immateriellen Bewusstsein erfolgt.

Mit grundlegend für die Simulations-Theorie war die sorgfältige Untersuchung der auffallenden Übereinstimmungen zwischen virtuellen Realitäten und den Erkenntnissen der modernen Physik durch den Informatiker Brian Whitworth (2008, 2010a, 2010b), der folgende Parallelen hervorhob:

- Inbetriebnahme: Jede Welt mit einem absoluten Anfang deutet darauf hin, dass diese Welt nicht so grundlegend ist, wie eine wirklich reale Welt sein müsste. Unsere Welt hat einen absoluten Anfang von Raum und Zeit vor etwa 14 Milliarden Jahren, was durch die Urknallkosmologie und das Borde-Guth-Vilenkin-Theorem (Borde et al. 2003) belegt wird. Gleichermaßen hat jede virtuelle Realität einen solchen „Urknall“ am Anfang, nämlich dann, wenn das Programm gestartet wird und dessen virtueller Raum und Zeit zu existieren beginnen. Aus der Perspektive der virtuellen Realität ist dieser Beginn scheinbar aus dem Nichts heraus, genau wie der Urknall. Eine weitere Parallele ist, dass beim Start eines Computerprograms die Variablen wohldefinierte Werte besitzen. Gleichermaßen weisen die physikalischen Konstanten unseres Universums eine verblüffende Feinabstimmung auf (Finetuning Problem).

- Pixeligkeit / Digitalität: In virtuellen Realitäten ist alles letztlich digitalisiert und diskret in Form von 2D-Pixel oder 3D-Voxel, da alle Einheiten eine minimale Größe besitzen müssen, die nicht weiter unterteilbar ist. Genauso sind in unserer Realität nicht nur Energie in kleinste diskrete Einheiten quantisiert, sondern ebenso Raum und Zeit in kleinste Längen (Planck-Länge und Planck-Zeit). Dadurch besitzt das Universum eine endliche Anzahl von Bausteinen und ist somit berechenbar. Dies steht nicht im Widerspruch zu der Tatsache, dass die Amplitude der Wellenfunktion kontinuierlich ist. Die Wellenfunktion des Universums ist ein Kontinuum (das Multiversum ist quasi analog), aber jede einzelne Welt ist diskret (digital). Die digitale Physik ist ein emergentes Phänomen aus der Perspektive innerhalb eines dekohärenten Weltzweiges.

- Grenzgeschwindigkeit: Es gibt in der realen Welt eigentlich keinen Grund, warum Geschwindigkeit nicht unbegrenzt erhöht werden kann. In virtuellen Realitäten gibt es jedoch stets ein Geschwindigkeitslimit, dass durch die maximale Geschwindigkeit der zentralen Recheneinheit vorgegeben ist. Auch unsere reale Welt hat mit der Lichtgeschwindigkeit eine solche maximale Grenzgeschwindigkeit.

- Prozessorlast-Beeinträchtigungen: Größere Prozessorlast, z.B. durch die Berechnung von mehr Objekten, verlangsamt die Verarbeitungsgeschwindigkeit des Computers. Genauso kommt es zu relativistischer Zeitdehnung in der Nähe von großen Materie-Konzentrationen. Dies ist in nicht-virtuellen Welten nicht zu erwarten. Es konnte zudem gezeigt werden, dass es sich hierbei nicht um eine zufällige, sondern um eine unmittelbare Übereinstimmung handelt (Jacobson 1995).

- Nicht-Realismus: Materie ist in einer virtuellen Realität nicht im beobachterunabhängigen Sinne real, sondern wird bei Bedarf für die Beobachtung gerendert. Genau dieser Beobachtereffekt wurde in der Quantenmechanik in den letzten Jahrzehnten immer wieder durch Experimente bestätigt, die einen Nicht-Realismus belegen und zeigen (Ananthaswamy 2018a), dass die diskreten Eigenschaften von Elementarteilchen erst existieren, wenn die Wellenfunktion durch die Beobachtung bzw. Messung (scheinbar) kollabiert. Lokaler Realismus wurde schon durch die experimentelle Verletzung der Bell‘schen Ungleichung widerlegt (Aspect et al. 1981, 1982a, 1982b, Weihs et al. 1998, Fuwa et al. 2015, Zych et al. 2019). Aber auch der nicht-lokale Realismus wurde inzwischen widerlegt, unter anderem durch die experimentelle Bestätigung des Kochen-Specker-Theorems (Kochen & Specker 1967, Klyachko et al. 2008, Lapkiewicz et al. 2011,) und die experimentelle Verletzung der Leggett-Garg-Ungleichung (Gröblacher et al. 2007, Kofler & Brukner 2008, Ma et al. 2013, 2016, Dressel & Korotkov 2013, Manning et al. 2015, Gachechiladze et al. 2016, Proietti et al. 2019). Entscheidend waren hierbei vor allem Experimente der Arbeitsgruppe von Prof. Anton Zeilinger (Ball 2007, Interview). Das Before-Before-Experiment der Arbeitsgruppe von Antoine Suarez und Nicolas Gisin widerlegt nicht nur einen nicht-lokalen Realismus, sondern beweist auch, dass die Verursachung der Quanteneffekte und somit die Ebene der fundamentalen Realität nicht raumzeitlicher Natur sein muss (Suarez 2007, 2008a, 2008b). Schließlich stellt auch das Frauchinger-Renner-Paradoxon ein Problem für die naive Vorstellung einer beobachterunabhängigen und eindeutigen Realität dar (Ananthaswamy 2018b, Frauchinger & Renner 2018).

- Nichtlokalität: Die Verbindungen zwischen Punkten innerhalb einer virtuellen Realität sind nicht limitiert durch den virtuellen Raum zwischen ihnen, denn alle Punkte einer virtuellen Realität sind äquidistant zum erzeugenden Prozessor. Daher unterliegen Wechselwirkungen zwischen Punkten bzw. Teilchen keiner räumlichen Begrenzung. In unserer Realität zeigt sich das Gleiche beim Phänomen der nichtlokalen Wechselwirkung von verschränkten Teilchen, bei denen die Messung eines Teilchens die Messung des anderen Teilchens unabhängig von dessen Entfernung sofort beeinflusst. Dieser von Einstein als spukhafte Fernwirkung (EPR-Paradoxon) bezeichnete Effekt (Einstein et al. 1935, Bell 1964) ist durch zahlreiche experimentelle Überprüfungen der Bell‘schen Ungleichung gesichert (siehe oben) und alle möglichen Schlupflöcher geschlossen.

- Komplementarität: Durch Einschränkungen der Prozessorlast können Computer Paare von Eigenschaften nicht an einem Ort gleichzeitig simulieren. Dies ist analog zu Heisenbergs Unschärfeprinzip in unserer Welt, welches besagt, dass Paare von Eigenschaften nicht gleichzeig mit einem bestimmten Grad an Genauigkeit gemessen werden können (Coles et al. 2014 beschrieben ein analoges Phänomen).

- Tunneleffekte: Auf Grund der limitierten Prozessorlast können Objekte und Hindernisse nicht gleichzeitig simuliert werden, was dazu führt, dass Objekte (z.B. in Computerspielen wie Minecraft) plötzlich jenseits einer Barriere erscheinen können. Dieses typische und grundsätzlich unvermeidbare Phänomen virtueller Realitäten zeigt sich genauso beim Quantentunneleffekt in unserer realen Welt. Eine entsprechende Erkenntnis findet sich beispielsweise auch in einem Vortrag von Philip Rosedale, dem Erfinder der virtuellen Welt Second Life.

In den Arbeiten von Whitworth werden noch eine ganze Reihe weiterer Parallelen aufgezeigt, deren Besprechung hier aber zu weit führen würde. Unbekannt war Whitworth offenbar die aufsehenerregende Entdeckung des Physikers James Gates, der herausfand, dass sich in den Formeln der Stringtheorie ein regelrechter binärer Programmcode für Fehlerkorrekturen verbirgt (Doran et al. 2008, Gates 2010, Interview). Dazu passt die Entdeckung, dass Raumzeit selbst auf einem Quanten-Fehlerkorrektur-Code basieren könnte (Wolchover 2019). Ein neues mögliches Argument ist die Arbeit des Physikers Vitaly Vanchurin (2020), der gezeigt hat, dass die fundamentalen Grundlagen der Physik (Quantenmechanik und Relativitätstheorie) und somit die Welt vollständig als neuronales Netzwerk zu erklären sind (siehe auch: Tangermann 2020).

Natürlich ist bei ein paar der Parallelen (z.B. Grenzgeschwindigkeit und Prozessorlastbeeinträchtigungen), die von Whitworth aufgezeigt wurden zumindest fraglich, ob diese nur für Simulationen auf finiten raumzeitlichen Recheneinheiten gelten, oder auch auf die von uns postulierte Simulation in einem unendlichen und zeitlosen Geist übertragbar sind.

Whitworths grundsätzliche Schlussfolgerung, dass Raumzeit nicht fundamentaler Natur ist, wird jedoch mittlerweile von zahlreichen theoretischen Physikern unterstützt und ist in den entsprechenden Fachkreisen zunehmend Konsens. An der Universität Bonn gab es 2017 eine eigene Fachtagung zum Thema "Spacetime: Fundamental or Emergent?". Princeton Professor Nima Arkani-Hamed spricht gar vom "Doom of Spacetime". Sowohl Vertreter der Stringtheorie (Horowitz 2005, Vistarini 2017, 2019) als auch Vertreter der alternativen Theorie der Schleifenquantengravitation (Markopoulou 2009) stimmen darin überein, dass Raumzeit kein fundamentales Element der Realität ist (Carroll 2010, 2019a, Huggett & Wüthrich 2017, Huggett et al. 2020), sondern ein emergentes Phänomen (Seiberg 2005, 2007, Crowther 2014, Yang 2015, 2016, Licata 2016, Romero 2017, Martens 2019), welches aus verschränkter Quanteninformation im Hilbert-Raum (Kryukov 2004, Cowen 2015, Carroll 2015, 2016, Lin et al. 2015, Cao et al. 2017, Nomura et al. 2018, Noorbala 2018, Swingle 2018, Gupta 2018, Musser 2018, Lee 2019, Siegfried 2019a, 2019b, Feldmann 2020b) jenseits von Raum und Zeit hervorgeht. Fundamental ist somit nicht die Raumzeit, sondern die ihr zu Grunde liegende Wellenfunktion, also pure Mathematik und Information. Untersuchungen zu Tensor-Netzwerken (z.B. AdS/MERA) legen zudem nahe, dass nicht nur der Raum, sondern auch Zeit (Moreva et al. 2014, Bao et al. 2015b, Zych et al. 2019) und Gravitation (Padmanabhan 2014, Siegfried 2014, Swingle & Raamsdonk 2014, Quellette 2015, Swingle 2018, Qi 2018) emergente Phänomene sind, die auf quantenphysikalischer Verschränkung basieren. Auch Verlinde (2017) kommt zu dem gleichen Ergebnis, dass sowohl Raumzeit als auch Gravitation gemeinsam aus verschränkter Quanteninformation emergieren. Interessanterweise impliziert auch Utiyamas Eichfeldtheorie der Gravitation eine emergente Natur von Raum und Zeit (Anderson 2020). Schließlich führt Jonathan Schaffer mit seinen "Quanten-Monismus" das ganze Multiversum auf verschränkte Quanteninformation als die eine fundamentale Realität zurück (Schaffer 2010, Ismael & Schaffer 2016, Calosi 2017, Päs 2019). Aus all diesen Gründen gibt es sogar ein großes internationales Forschungsprojekt mit dem Titel "It from Qubit" (Moskovitz 2016) zu diesem Themenkomplex der Emergenz der Raumzeit und Gravitation aus Quanteninformation. Ein unabhängiges Argument ergibt sich unter Umständen aus Landauers Prinzip, von dem sich eine Äquivalenz von Materie-Energie und Information ableiten lässt (Vopson 2019).

Vergleichbare Schlussfolgerungen können auch schon aus den bekannten Beobachtungen der gewöhnlichen Quantenmechanik gezogen werden. Raum ist definitionsgemäß eine Ortsbestimmung. Aus dem Nicht-Realismus der Quantenmechanik folgt, dass eine solche Ortsbestimmung nicht vor der Messung existiert (Rosenblum & Kuttner 2006, Gröblacher et al. 2007). Beispielsweise existiert die räumliche Trennung zweier verschränkter Teilchen, zumindest aus deren Bezugsrahmen nicht, da beide in Superposition sind und keinen definierten Ort haben. Zudem kann auf Grund der Existenz einer Universellen Wellenfunktion (UWF) (Moreva et al. 2014), diese illusionäre Natur des Raumes und der Zeit verallgemeinert werden, da die UWF eine universelle Verschränkung in ihrem Bezugssystem mit sich bringt.

Auch die aus der Forschung über das Problem des Informationsverlustes in Schwarzen Löchern gewonnene Erkenntnis des Holographischen Prinzips spricht gegen eine fundamentale Natur der Raumzeit und für die Simulations-Hypothese (Glattfelder 2019). Dieses sehr kontraintuitive Prinzip besagt vereinfacht ausgedrückt, dass der maximale Informationsgehalt (Bekenstein-Grenze) eines Raumabschnittes nicht durch dessen Volumen, sondern nur durch dessen Oberfläche limitiert ist (siehe diesen Vortrag von Leonard Susskind). Der dreidimensionale Raum scheint daher wie eine holographische Projektion eines zweidimensionalen Quantenfeldes zu sein (Brian Greene 2014). Anfangs nur eine umstrittene Theorie ist das Holographische Prinzip (Susskind 1995) inzwischen experimentell bestätigt (Afshordi et al. 2017) und allgemein anerkannt. Ein weiterer Hinweis in diese Richtung ist die AdS/CFT-Korrespondenz („holographic duality“) zwischen Quantengravitation und Quantenfeldtheorie (Maldacena 1999, eine der meistzitierten Arbeiten in der modernen Physik!), sowie die damit zusammenhängende ER=EPR-Korrespondenz, welche bedeutet, dass die Verschränkung von zwei Teilchen in der zweiten Dimension äquivalent zu einer Wurmlochverbindung in der dritten Dimension ist (El-Showk & Papadodimas 2012, Maldacena & Susskind 2013, Bao et al. 2015a, Susskind 2016, Cao et al. 2017).

Schließlich gibt es noch ein mysteriöses Quantenexperiment, dass darauf hinweist, dass nicht nur der Raum, sondern auch die Zeit, einschließlich der Vergangenheit, nicht real ist. Es handelt sich um das sogenannte „Delayed-Choice Quantum Eraser“ Experiment, eine trickreiche Variante des berühmten Doppelspalt-Experimentes (Kim et al. 2000, Jacques et al. 2007, Ma et al. 2012, 2013, Huang et al. 2019). Die Folgerung auf eine Retrokausalität und somit auf eine nicht festgelegte Vergangenheit kann nur dann vermieden werden (aber siehe Ellerman 2012), wenn als zutreffende Interpretation der Quantenmechanik die Viele-Welten-Deutung angenommen wird (Everett 1956, 1957, Carroll 2019a,b). Allerdings hat die bei Physikern derzeit sehr beliebte Viele-Welten-Deutung oder Everett-Interpretation auch eine Reihe von Problemen (Lane 2011, Jones 2014a, Dawid & Thébault 2015, Leifer & Pusey 2017, Ball 2018, Gao 2018, Hossenfelder 2019, Kersgaard 2019), die sie unseres Erachtens zumindest ergänzungsbedürftig macht:

- Als das schwerwiegendste Problem der Vielen-Welten-Deutung wird oft das Problem der bevorzugten Basis genannt (Stapp 2002), beruhend auf der Tatsache, dass es auf Grund der Wellenfunktion nicht nur diskrete alternative Möglichkeiten gibt, sondern in unterschiedlichem Ausmaß überlagerte Möglichkeiten. Schrödingers Katze ist eben nicht nur in einer möglichen Welt tot und in einer anderen lebendig, sondern in manchen Welten in merkwürdigen Mischzuständen (sozusagen lebot und totendig). Allerdings gilt dieses Problem durch Dekohärenz (Einselektion und Quanten-Darwinismus sensu Zurek) und "permanent spatial decomposition" inzwischen meist als gelöst (Galvan 2010, Carroll 2019a).

- Ein weiterer Kritikpunkt ist die Ableitung der Born’schen Regel, die für die Quantenmechanik von zentraler Bedeutung ist (Blood 2009b). Das Problem ist, dass die Quantenmechanik distinkte Wahrscheinlichkeiten für bestimmte Resultate vorgibt, während aus der Viele-Welten-Deutung folgt, dass alle Resultate die gleiche Wahrscheinlichkeit (nämlich 1) haben. Auch hier meinen Vertreter der Viele-Welten-Deutung, dass dieses Problem von David Deutsch und David Wallace durch Anwendung der Entscheidungstheorie sowie die epistemische Unsicherheit der "Self-Location" gelöst ist (Carroll 2019a). Es gibt jedoch zahlreiche Kritiker dieses Ansatzes und ein Konsens ist nicht in Sicht (Boge 2016). Davon einmal abgesehen kann die Born'sche Regel übrigens auch von keiner anderen Interpretation der Quantenmechanik direkt abgeleitet werden, sondern ist schlicht eine vorausgesetzte Annahme.

- Ein neuer Kritikpunkt ist die Behauptung, dass die Viele-Welten-Deutung widersprüchlich sei, weil sie realistisch und zeitsymmetrisch ist aber keine Retrokausalität erlaubt, was ein No-Go-Theorem von Leifer & Pusey (2017) verletzt.

- Luboš Motl (2015, 2019) diskutiert ein weiteres (bislang meist übersehenes) fatales Problem aller realistischen Interpretationen der Quantenmechanik, zu denen neben Bohmscher Mechanik und Spontaner Kollapstheorie (GRW) auch Everetts Viele-Welten-Deutung zählt. Das Problem ist, dass diese Interpretationen mehr Freiheitsgrade implizieren als experimentell beobachtet werden und somit der Boltzmann Konstante widersprechen.

- Schließlich wird oft gesagt, dass die Viele-Welten-Deutung absurde Konsequenzen habe (Ball 2018), die beispielsweise durch das Gedankenexperiment des Quanten-Selbstmordes veranschaulicht werden. Weitere absurde Konsequenzen ergeben sich aus dem impliziten modalen Realismus, in dem es keinen Unterschied mehr gibt zwischen Möglichem und Realem. Alles was möglich ist, egal wie unwahrscheinlich oder verrückt, geschieht auch tatsächlich. Allerdings hat natürlich jede Interpretation der Quantenmechanik unanschauliche und unintuitive Aspekte.

Unseres Erachtens könnte die Everett-Interpretation nur dann vollständig sein, wenn Bewusstsein als zentrale Komponente einbezogen wird. Dies würde eher eine Synthese der Viele-Welten-Deutung mit der Many-Minds-Interpretation impliziere, oder mit perspektivischen Elementen der Relationalen Interpretation der Quantenmechanik. Beispielsweise könnte Bewusstsein in folgender Form zur Lösung des Problems der bevorzugten Basis beitragen: Information bedeutet Reduktion von Alternativen. Dekohärenz erhöht durch Reduktion von Alternativen den Informationsgehalt. Auf Grund der Theorie der Integrierten Information steigt mit dem Informationsgehalt auch der Grad des Bewusstseins. Folglich sind nur vollständig dekohärente Gehirne maximal bewusst, während Zustände der Superposition durch vermindertes Bewusstsein nicht wahrgenommen werden. Tononis Theorie der Integrierten Information liefert ganz neue Ansätze für die Beziehung von Bewusstsein und dem (vermeintlichen) Kollaps der Wellenfunktion (Okon & Sebastián 2018).

Auch die "Vielen Welten" sind ggf. nur ein emergentes Phänomen aus einer tiefer liegenden Quantenrealität, denn die moderne Everett-Interpretation geht nicht mehr von sich ständig verzweigenden Welten aus, sondern sieht die klassischen Welten als emergentes Phänomen der universellen Wellenfunktion im Hilbertraum (Wellenfunktions-Monismus) (Smith 1997, Solé & Hoefer 2016, calosi 2017, Päs 2019, Tappenden 2019, Parrochia 2020). Dies ist besonders Evident in Zureks Existenzieller Interpretation (Zurek 2018), in der klassische Existenz durch Quanten-Darwinismus aus Quanteninformation emergiert und somit Wheelers Diktum "It from Bit" erfüllt. Die Viele Welten Interpretation fügt sich somit zwanglos in unser Modell des Quanten-Idealismus. Die Realität der Wellenfunktion ist, ganz im Gegensatz zu deren epistemischer Interpretation, inzwischen auch durch experimentelle Daten unterstützt (Pusey et al. 2012, Branciard 2014, Ringbauer et al. 2015, Manzano 2015, Nova 2015, Slezak 2015, Ringbauer 2017). Unseres Erachtens sollten alle Interpretationen der Quantenmechanik ausgeschlossen werden, die entweder den mathematischen Formalismus ergänzen und/oder ad hoc einen Kollaps-Mechanismus hinzufügen (quasi "Theorien der verschwindenden Welten"). Vertreter der Viele-Welten-Deutung betonen zudem zurecht, dass alle indeterministischen Interpretationen auf Grund des fundamentalen Zufallselementes nicht wirklich erklären können (und wollen), warum gerade genau dieses Resultat gemessen wird anstatt eines anderen. Dies scheint jedoch die erst zu beweisende Behauptung als wahr vorauszusetzen, nämlich dass der Indeterminismus unzutreffend ist, was aber mit dem logischen Satz von zureichenden Grund gerechtfertigt werden könnte, mit dem ein Indeterminismus grundsätzlich inkompatibel ist (Mashkevich 2010), so dass alle indeterministischen Interpretationen der Quantenmechanik aus logischer Notwendigkeit falsch sein müssten (allerdings gibt es auch gewichtige Argumente aus der Informationstheorie und Mathematik gegen den Satz vom zureichenden Grund, z.B. Chaitin 2006, 2008).

Die Implikationen der merkwürdigen Ergebnisse der Quantenmechanik können nicht mehr nur auf die Welt der kleinsten Elementarteilchen beschränkt werden, denn erstens sind ja alle makroskopischen Objekte aus solchen Elementarteilchen zusammengesetzt, und zweitens ist Quantenverschränkungen inzwischen experimentell schon bis in den Größenbereich sichtbarer Objekte gelungen (Brumfiel 2010, Gerlich et al. 2011, Klimov et al. 2015, Ockeloen-Korppi et al. 2018, Fein et al. 2019). Die einzigen alternativen Interpretationen der Quantenmechanik, die eine solche "magische" Grenze zwischen mikroskopischer Quantenwelt und makroskopischer Klassier Realität überhaupt ermöglichen würden, sind sogenannte dynamische Kollapstheorien (z.B. Girardi-Rimini-Weber Interpretation), mit einem schwerkraft-induzierten, zufälligen Kollaps der Wellenfunktion. Damit handelt es sich grundsätzlich um von der Standard-Quantenmechanik unterschiedliche Theorien, die somit experimentell überprüfbar sind. Entsprechende Experimente sind derzeit in Arbeit und werden wohl noch 2021 durchgeführt (Skibba 2020). Unsere Vorhersage ist daher, dass die dynamischen Kollapstheorien in Kürze experimentell widerlegt sein werden.

Das Problem der Beziehung zwischen abstrakten Gegenständen (wie der Mathematik) und der physikalischen Realität kann nur durch eine idealistische Metaphysik gelöst werden. Dies gilt insbesondere auch für die Beziehung zwischen abstrakten Ideen und unseren neurophysiologischen Hirnzuständen. Im Quanten-Idealismus gibt es keine unüberbrückbare Kluft zwischen immateriellen und zeitlosen, abstrakten Gegenständen, die im Hilbert-Raum existieren, und der raumzeitlichen physikalischen Realität, die aus diesem Hilbert-Raum emergiert. Wigners Problem der mysteriösen Nützlichkeit der Mathematik in den Naturwissenschaften (Wigner 1960) und das geistesphilosophische Problem der Intentionalität finden somit eine elegante Lösung. Auch Max Tegmarks „Mathematisches Universum“ (eine Art pythagoreischer Monismus) impliziert eine idealistische Metaphysik, denn Mathematik basiert auf Konzepten und Ideen, die einen bewussten Geist als Träger voraussetzen (aber siehe Anhang 2 unten). Da diese universell gültigen Konzepte offensichtlich nicht auf unser individuelles Bewusstsein beschränkt sind, müssen sie in einem universellen Bewusstsein existieren. Auch Tegmark selbst verbindet inzwischen seine Hypothese mit Tononis panpsychistischer Theorie der Integrierten Information, die zunehmend als die derzeit führende wissenschaftliche Theorie des Bewusstseins anzusehen ist (eine interessante Variante ist Johnjoe McFaddens 2020 Synthese von Tononis IIT mit einer EM-Feldtheorie des Bewusstseins).

Zu einer idealistischen Schlussfolgerung gelangt man auch durch eine Verbindung der modernen Physik der emergenten Raumzeit mit den kognitionswissenschaftlichen Theorien von Donald Hoffmans Bewusstseins-Realismus und Interface-Theorie (Hoffman 2008, 2014, 2019, Hoffman & Prakash 2014, Hoffman et al. 2015, Fields et al. 2017) und Giulio Tononis Theorie der Integrierten Information (Tononi 2008, 2012, Lamme 2010, Tononi & Koch 2014, Oizumi et al. 2014, Hoel et al. 2016, Musser 2017). Diese implizieren eine Äquivalenz von Quantenverschränkung und Bewusstsein (Tononi 2008, Zanardi et al. 2018, Kleiner & Tull 2020, Tull & Kleiner 2020, Brooks 2020). Zusammengenommen folgt, dass die Raumzeit eine kognitive Quantensimulation innerhalb eines universellen Bewusstseins ist. Auch Barkai (2019) sieht eine direkten Zusammenhang zwischen Quantenverschränkung und Bewusstsein. Eine solche direkte Beziehung zwischen Quantenphänomenen und Bewusstsein wird durch zahlreiche unabhängige Ansätze nahegelegt (Meijer & Raggett 2014) und zudem durch die Forschung im Bereich Bereich der Quanten-Kognition belegt (Aerts 2009, Bruza et al. 2015), welche gezeigt hat, dass Denkvorgänge mittels der Schrödinger-Gleichung exakt modelliert werden können. Hinzu kommen vermehrte Hinweisen auf Quanten-Berechnungen im Gehirn (Faber et al. 2006, Hameroff & Penrose 2014, Cocchi et al. 2017) und weitere Forschung zur Quantenbiologie des Gehirns (John 2002, Agrawal et al. 2018), die in die gleiche Richtung weisen.

Ein vorläufiges deduktives Argument für den Quanten-Idealismus könnte folgermaßen formuliert werden:

- Prämisse 1: Es gibt eine Wellenfunktion des Universums.

- Prämisse 2: Die Wellenfunktion der Quantenmechanik ist real, aber nicht raumzeitlich-physikalischer Natur, sondern mathematischer Natur (Dorato 2015a).

- Prämisse 3: Mathematische Gegenstände sind abstrakte Konzepte, die einen bewussten Geist als Träger voraussetzen.

- Schlussfolgerung: Es gibt ein universelles Bewusstsein, in dem die Wellenfunktion des Universums "lebt".

Die oben aufgeführten Hinweise zu Gunsten eines Quanten-Idealismus können zudem in folgendem deduktiven „Gottesbeweis“ zusammengefasst werden, der unser zentrales Argument darstellt:

- Prämisse 1: Raumzeit emergiert aus verschränkter Information (AdS/CFT-Korrespondenz bestätigt durch Cao 2017, sowie experimentelle Bestätigungen von Bells und Leggetts Ungleichungen, siehe oben und siehe Ball 2020).

- Prämisse 2: Verschränkung von Information ist gleichbedeutend mit Integration von Information und somit gleichbedeutend mit Bewusstsein (Theorie der Integrierten Information von Tononi 2008, experimentell bestätigt von John 2002 durch quantenbiologische Effekte der Gamma-Synchronität unter Narkose; zudem laut Ball 2019 in Kürze experimentell überprüft durch großes Projekt der Tempelton-Stiftung).

- Schlussfolgerung 1: Raumzeit emergiert aus Bewusstsein.

- Prämisse 3: Es gibt eine einzige Universelle Wellenfunktion UWF, welche die Verschränkung aller Materie-Energie und somit aller Information in einen einzigen integrierten Informationszustand impliziert (Wheeler-DeWitt-Gleichung, experimentell bestätigt durch Moreva et al. 2014).

- Schlussfolgerung 2: Die physikalische Raumzeit ist emergent aus einem einzigen universellen Bewusstsein (und dieses nennen wir Gott). Da die digitale Physik, wie oben erwähnt ein emergentes Phänomen innerhalb dekohärenter Weltzweige ist, aber die Wellenfunktion des Universums kontinuierlich ist, folgt daraus auch, dass die fundamentale Natur der Realität kontinuierlich (analog) ist. Der Geist Gottes ist ein unendliches, unteilbares Ganzes, wie von Plato als das 'EINE' oder wie im klassischen Theismus (Stichwort "divine simplicity") beschrieben.

[Hinweis: Ein möglicher Einwand könnte das Exklusionprinzip der Theorie der Integrierten Information sein, das nur dem jeweils höchsten System innerhalb einer verschachtelten Hierarchie Bewusstsein zuspricht. Dies könnte bedeuten, dass das obige Argument zeigt, dass es nur ein kosmisches Bewusstsein geben könnte, aber z.B. keine bewussten Wesen innerhalb des Kosmos. Dies wäre jedoch ein Missverständnis des Quanten-Idealismus, der ja einen Bewusstseins-Monismus postuliert. Es gibt demnach keine wirklich getrennten Bewusstseine, sondern tatsächlich nur ein universelles Bewusstsein, während die scheinbare Getrenntheit der verkörperten Bewusstseine nur eine Illusion ist.]

Angesichts der offensichtlichen theistischen Implikationen dieser Schlussfolgerung ist es nicht verwunderlich, dass diese Erkenntnisse auch wichtige Auswirkungen auf die Theorie des Intelligenten Designs haben können. Verbindet man Modelle der Quanten-Evolution (McFadden & Al-Khalili 1999, 2001, McFadden 2002, Goswami 2008, Griffin 2008, Ogryzko 2009, Schäfer 2009, Merali 2014, Elsheik 2016, Hameroff 2017, Nemer et al. 2017) und der Verschränkung von DNA (Rieper et al. 2010) mit unserem Modell des Quanten-Idealismus, so lässt sich ein konkreter Mechanismus für Intelligentes Design ableiten. Mutationen erfolgen demnach nicht zufällig (vergl. Kastrup 2019a), sondern sind Quantenberechnungen im Zustand der DNA-Verschränkung, wobei vorteilhafte Mutationen ein höheres Gewicht haben als schädliche Mutationen, weil sie in mehr Zweigen der Wellenfunktion überleben und propagieren. Zudem postulieren wir einen ontologischen Status der evolutionären Fitnesslandschaft als Teilmenge des Hilbertraumes, denn beide sind distinkte Mengen alternativer Möglichkeiten. Durch die oben erwähnte mentale Natur der universellen Wellenfunktion ist dieser Prozess zielgerichtet. Man könnte auch sagen, dass bestimmte platonische Formen als morphogenetische Attraktoren wirken (vergl. Sheldrake 1981, Griffin 2008), welche nicht-zufällige, adaptive Makro-Mutationen kanalisieren. Oder um in der Computermetapher zu bleiben: Neue Information wird aus der Cloud heruntergeladen. Daraus resultiert ein sprunghafter und teleologischer Evolutionsprozess, der in den allgegenwärtigen Diskontinuitäten des Fossilberichtes seine Bestätigung findet. Zusätzlich könnte eine idealistische Deutung (Kastrup 2012) von Rupert Sheldrakes Theorie der Morphischen Resonanz als Gedächtnis der Natur das Phänomen der allgegenwärtigen Konvergenzen besser erklären, insbesondere Fälle von parallelen Entwicklungen in nahe verwandten Gruppen (sogenannte "underlying synapomorphies" senu Sæther 1983, wie z.B. der einzigartige horizontale Backenzahlwechsel bei Elefanten und Seekühen, der jedoch jeweils bei frühen fossilen Vertretern der beiden Gruppen fehlt), insbesondere wenn diese Konvergenzen auch noch zeitlich koordiniert sind (z.B. die plötzliche unabhängige Entstehung von 15 Familien mariner Reptilien in der frühen Triaszeit). Unser hier postuliertes saltatorisches Model steht somit in einer langen Tradition nicht-darwinistischer Evolutionstheorien wie Teilhard de Chardins (1955) Orthogenese und Albert von Köllikers (1864) Heterogenese, D’Arcy Thompsons (1917, 1940) mathematischer Transformationen, der „Hopeful Monster“-Hypothese von Geoffroy Saint-Hilaire und Richard Goldschmidt (1940) (Gould 1977, Theißen 2006, Rieppel 2001, 2017), Otto Schindewolfs (1950) Typostrophenlehre, Michael Polanyis Emergentismus (Paksi 2012), sowie der Annahme eines sprunghaften Mutationismus bei Hugo de Vries und Thomas Hunt Morgan (Bowler 1978). Die hier befürwortete Hypothese einer teleologischen Quanten-Evolution ist durchaus vereinbar mit einer begrenzten Neo-Darwinistischen Mikroevolution sowie mit Prozessstrukturalismus (Jones 2018), der eine weitere teleologische Ebene hinzufügt, nämlich feinabgestimmte Naturgesetze (Laws of Form) und feinabgestimmte Fitness-Landschaften. Die Interpretation von Evolution als zielgerichtete Quantenberechnung ist zudem kongruent mit der modernen Definition von Leben als informationsverarbeitendem Prozess (Walker & Davies 2013, Davies 2019).

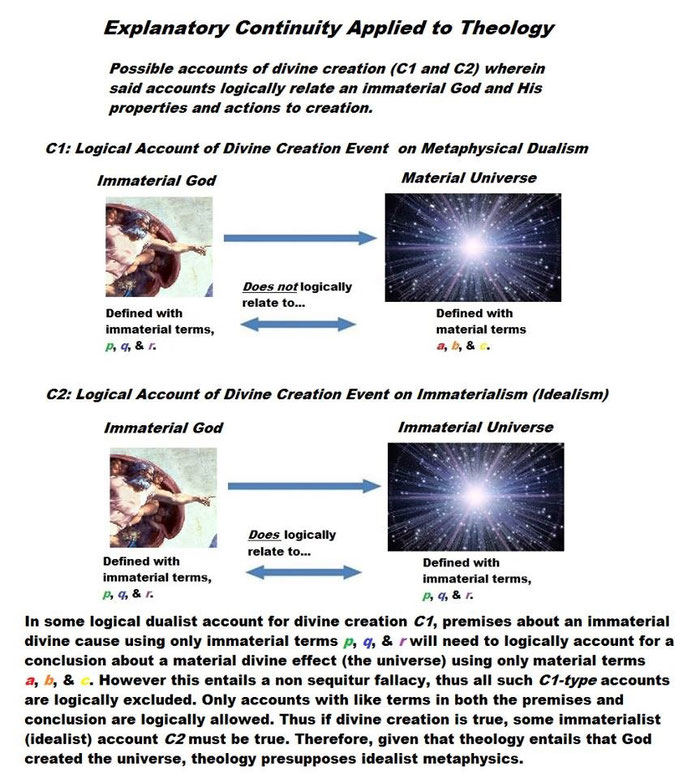

Verschiedene theologische Konsequenzen folgen ebenfalls aus den obigen Überlegungen. Quanten-Idealismus ist mit verschiedenen religiösen Traditionen vereinbar (insbesondere deren mystischen und esoterischen Formen) und hat eine besondere Nähe zur Philosophia perennis, Prisca theologia und Hermetik (Jordan 2016, Palmer & Palmer 2018). Unvereinbarkeit besteht natürlich mit den simplistischen und naiven Interpretationen fundamentalistischer Glaubensrichtungen, die oft eher an Cargo-Kulte erinnern. Hingegen haben eine ganze Reihe bedeutender christlicher Philosophen und Theologen, wie beispielsweise Bischof George Berkeley, Jonathan Edwards (1957), Robert Adams (2007), Keith Ward (2010) und Bruce Gordon (2017), in der Vergangenheit auch die grundsätzliche Vereinbarkeit von anspruchsvollem christlichem Glauben und idealistischer Metaphysik aufgezeigt. Unser Modell erlaubt unter Umständen sogar die rationale Ableitung und Begründung klassischer christlicher Doktrinen, wie beispielsweise eine neuartige Interpretation des Sündenfalls (ein Verlust der Verschränkung mit dem universellen Bewusstsein) (Alander 2020), eine Physik der Wunder (Raatz 2016), eine stringente mathematische Rekonstruktion der Trinität und ihrer Omni-Attribute aus der Dynamik bewusster Agenten (sensu Hoffman & Prakash 2014) (Raatz 2013, 2017) sowie sogar die Begründung geistiger Entitäten wie Engel und Dämonen (Raatz 2020). Eine kompatible Christologie folgt am Besten in Anlehnung an die Vorstellungen von Teilhard de Chardin und der von Frank Tipler modernisierten Form der Omega-Punkt-Theorie (Tipler 2008). Auch die im klassischen Theismus zentrale Unterscheidung zwischen Schöpfer und Schöpfung kann rational in unserem Modell hinreichend begründet werden. Diese Unterscheidung ist kompatibel mit einem schwachen (palamitischen) Panentheismus und seiner Unterscheidung zwischen göttlicher Essenz und göttlichen Energien (Jones 2014b), was einen reinen Pantheismus oder einen wandelbaren Gott der Prozessphilosophie vermeidet. Die entsprechende theoretische Ableitung folgt aus einer Anwendung von Carlo Rovellis (1996) Relationaler Interpretation der Quantenmechanik (scheinbarer Kollaps der Wellenfunktion ist relativ zum Bezugssystem, vergl. Soltau 2010) auf unser Modell des Quanten-Idealismus. Im Gegensatz zu dualistischen Vorstellungen vermeidet ein monistischer Idealismus das oft unterschätzte Gott-Welt-Problem (eine Variante des bekannteren Problems der Seele-Körper-Interaktion), welches aus einem Non sequitur Fehlschluss resultiert, beruhend auf einer mangelnden explanatorischen Kontinuität zwischen Gott und Welt (siehe Abbildung unten). Theismus impliziert daher mit logischer Notwendigkeit eine idealistische Metaphysik. In diesem Zusammenhang ist es zumindest eine interessante Tatsache, dass die neuronalen Vernetzungen in unserem Gehirn eine auffallende Ähnlichkeit zu den Galaxien-Netzwerken des Universums besitzen (Krioukov et al. 2012, Zverina 2012, Vazza & Feletti 2017, 2020), die auch von Mainstream-Wissenschaftsmedien nicht länger ignoriert werden kann (Starr 2020), und quasi die materielle Entsprechung des Geist Gottes wäre (Kastrup 2015). Eine solche idealistische Metaphysik erlaubt auch eine neue Sicht des Hylemorphismus in der aristotelisch-thomistischen Philosophie, die im christlichen Denken (insbesondere in der Katholischen Kirche) eine große Rolle spielt: Prima Materia (hyle) ist demnach die reine Potenzialität des universellen Bewusstseins als "Container" für konkrete Bewusstseinsinhalte, während diese konkreten Inhalte die substantielle Form (morphe) darstellen, die das Bewusstsein in-formieren und damit in eine konkrete Form aktualisieren. Beide sind untrennbar miteinander verbunden und keines von Beiden existiert ohne das jeweils Andere.

Auswirkungen hat unser Modell auch auf den Transhumanismus, der von Manchen auch als säkulare Pseudo-Religion angesehen wird. Seine Vertreter gehen oft davon aus, dass wir durch exponentielle Fortschritte der künstlichen Intelligenz irgendwann unser Bewusstsein digital kopieren und in die Cloud hochladen können, um dort eine Form von Unsterblichkeit in einem virtuellen Paradies genießen können. Sowohl die Ergebnisse der Bewusstseinstheorie der Integrierten Information als auch die Ergebnisse zur Quantenbiologie des Gehirns könnten es jedoch (zumindest mittels klassischer Computer) grundsätzlich unmöglich machen, das menschliche Bewusstsein unter Erhaltung der persönlichen Identität digital zu kopieren (u.a. auch wegen des No-Cloning-Theorems in der Quantenphysik). Ein möglicher Ausweg wäre jedoch vielleicht das Phänomen der Quanten-Teleportation, die in den Experimenten von Anton Zeilinger schon bei einzelnen Teilchen gelungen ist. Dieses Problem besteht natürlich nur dann, falls es überhaupt so etwas wie diachrone persönliche Identität im Sinne eines überdauernden Selbst gibt, was von einigen bedeutenden Philosophen (wie z.B. Derek Parfit 1971, 1984) mit guten Gründen bezweifelt wird. Das sogenannte Doomsday-Argument ist jedoch in jedem Falle ein schwerwiegendes Problem für jegliche Annahme einer sehr langen oder unendlichen Zukunft untypischer Beobachtermomente, sei es in einer StarTrek-Zukunft unter den Sternen, in einem digitalen "Paradies" (Bostrom 1998, 2002, Gerig 2012, Gerig et al. 2013), oder gar in einem religiösen Jenseits (Leslie 2008, Page 2008), außer die Viele-Welten-Deutung der Quantenmechanik trifft zu, was die Wahrscheinlichkeit für langfristiges Überleben unserer Zivilisation zumindest in einigen Zweigen der Wellenfunktion auf praktisch 100% erhöhen würde.

Abschließend sei noch kurz erwähnt, dass eine monistisch-idealistische Metaphysik auch Fragen der Tierrechte, Naturrechte und Tiefenökologie berührt. Dies zeigt sich unter anderem in den Arbeiten des idealistischen Philosophen Timothy Sprigge (Sprigge 1979, 1984b, 1987), der zeigte, dass in einem Absoluten Idealismus intrinsischer Wert nicht auf die menschliche Natur beschränkt ist, aber dennoch stets eines wahrnehmenden Bewusstseins bedarf um realisiert zu werden.

Die hier nur angedeuteten Modelle sind aktueller Gegenstand unserer gemeinsamen Forschung und großteils noch nicht veröffentlicht. Die Simulations-Hypothese (oft auch Matrix-Hypothese genannt) erfreut sich derzeit zunehmender Beliebtheit bei Physikern (z.B. Martin Rees, John Barrow 2007, Neil deGrasse Tyson und Michio Kaku), Philosophen wie Nick Bostrom (2003) und High-Tech Vordenkern wie Marvin Minsky, Elon Musk und Ray Kurzweil (1999). Es ist offensichtlich, dass es sich dabei um nichts anderes als eine nicht-theistische Version des Design-Argumentes handelt. Dies zeigt, dass der Bereich der Digitalen Physik und des Quanten-Idealismus die einzigartige Möglichkeit birgt, eine Brücke zwischen den Vertretern des Naturalismus und des Theismus sowie zwischen Vertretern des Darwinismus und des Intelligenten Designs zu schlagen. Zudem ermöglich dieser Ansatz nicht nur den vermeintlichen Konflikt zwischen Religion und moderner Wissenschaft aufzulösen, sondern Religion und Metaphysik in der Physik des 21. Jahrhunderts zu begründen und sicher zu verankern. Metaphysik ist damit nicht länger ein Gefangener philosophischer Beliebigkeit und die Existenz Gottes nicht länger eine reine Glaubensfrage. Der übernatürliche Theismus der Vergangenheit wird zu einem theistischen Naturalismus, bzw. wird die Übernatürlichkeit und Transzendenz Gottes zu einem wissenschaftlich fassbaren Begriff und Intelligentes Design wird zu einem Teil einer neuen Evolutionsbiologie jenseits der erwiesenen Unzulänglichkeit des Neo-Darwinismus (Nagel 2012, Müller 2017) und der absehbaren Unvollkommenheit einer immer mehr Erweiterten Synthese („Extended Evolutionary Synthesis“).

Quellen:

- Adams R. 2007. Idealism Vindicated. S. 40 in: Inwagen P.v. & Zimmerman D. (Hrsg.). Persons: Human and Divine. Oxford University Press.

- Aerts D. 2009. Quantum Structure in Cognition. Journal of Mathematical Psychology 53(5), 314–348. DOI: 10.1016/j.jmp.2009.04.005, arXiv:0805.3850.

- Afshordi N., Coriano C., Delle Rose L., Gould E. & Skenderis K. 2017. From Planck data to Planck era: Observational tests of Holographic Cosmology. Physical Review Letters 118, 041301. DOI: 10.1103/PhysRevLett.118.041301, arXiv:1607.04878.

- Agrawal L., Chhajed R., Ghosh S., Ghosh B., Ray K., Sahu S., Fujita D. & Bandyopadhyay A. 2018. Fractal Information Theory (FIT)-Derived Geometric Musical Language (GML) for Brain-Inspired Hypercomputing. S. 343-372 in: Pant M., Ray K., Sharma T., Rawat S. & Bandyopadhyay A. (Hrsg.). Soft Computing: Theories and Applications. Advances in Intelligent Systems and Computing Vol. 584. Springer Nature, xxii+781 S. DOI 10.1007/978-981-10-5699-4_33.

- Alander K. 2020. Quantum Hermeticism #8: Fallen State & Salvation Metaphysics. Christian Idealism 08.05.2020.

- Albahari M. 2019. Beyond Cosmopsychism and the Great I Am: How the World might be Grounded in Universal ‘Advaitic’ Consciousness. 12 S. in: Saeger W.E. (Hrsg.). The Routledge Handbook of Panpsychism. Oxford University Press, 396 S. DOI: 10.4324/9781315717708. [PDF]

- Ananthaswamy A. 2017. Inside knowledge: Is information the only thing that exists? NewScientist 29. März 2017.

- Ananthaswamy A. 2018a. Closed Loophole Confirms the Unreality of the Quantum World. Quanta Magazine 25. Juli 2018.

- Ananthasmway A. 2018b. New Quantum Paradox Clarifies Where Our Views of Reality Go Wrong. Quanta Magazine 3. Dezember 2018.

- Anderson T. 2020. Gauge Theoretic Gravity: Why space and time might be illusions. Medium 15. Mai 2020.

- Aspect A., Grangier P. & Roger G. 1981. Experimental Tests of Realistic Local Theories via Bell's Theorem. Physical Review Letters 47(7), 460–463. DOI: 10.1103/PhysRevLett.47.460.

- Aspect A., Grangier P. & Roger G. 1982a. Experimental Realization of Einstein-Podolsky-Rosen-Bohm Gedankenexperiment: A New Violation of Bell's Inequalities. Physical Review Letters 49(2), 91–94. DOI: 10.1103/PhysRevLett.49.91.

- Aspect A., Dalibart J. & Roger G. 1982b. Experimental Test of Bell's Inequalities Using Time-Varying Analyzers. Physical Review Letters 49(25), 1804–1807. DOI: 10.1103/PhysRevLett.49.1804.

- Balashov Y. & Janssen M. 2003. Presentism and Relativity. The British Journal for the Philosophy of Science 54(2), 327–346. DOI: 10.1093/bjps/54.2.327.

- Ball P. 2007. Physicists bid farewell to reality? Nature News 18. April 2007.

- Ball P. 2018. Why the Many-Worlds Interpretation Has Many Problems. QuantaMagazine 18. Oktober 2018.

- Ball P. 2019. Neuroscience Readies for a Showdown Over Consciousness Ideas. QuantaMagazine 6. März 2019.

- Ball P. 2020. Wormholes Reveal a Way to Manipulate Black Hole Information in the Lab. QuantaMagazine 27. Februar 2020.

- Bandyopadhyay A. 2020. Nanobrain: The Making of an Artificial Brain from a Time Crystal. CRC, 372 S. DOI: 10.1201/9780429107771.

- Bao N., Pollack J., Remmen G.N. 2015. Wormhole and entanglement (non-)detection in the ER=EPR correspondence. Journal of High Energy Physics 2015:126, 1–12. DOI: 10.1007/JHEP11(2015)126.

- Bao N., Cao C., Carroll S.M., Chatwin-Davies A., Hunter-Jones N., Pollack J. & Remmen G.N. 2015. Consistency conditions for an AdS multiscale entanglement renormalization ansatz correspondence. Physical Review D 91(12), 125036, 1–18. DOI: 10.1103/PhysRevD.91.125036, arXiv:1504.06632.

- Barkai A (2019). On the Psycho-Physical Parallelism. Semantic Scholar, 67 S.

- Barrow J 2007. Living in a Simulated Universe. Chapter 27 in: Universe or Multiverse? Cambridge University Press, 481–486. DOI: 10.1017/CBO9781107050990.029.

- Bass L. 1971. The mind of Wigner’s friend. Hermathena 112, 52–68. JSTOR:23040667.

- Bell J.S. 1964. On the Einstein Podolsky Rosen Paradox. Physics 1(3), 195–200 (PDF).

- Besnard F. 2011. Time of Philosophers, Time of Physicists, Time of Mathematicians. 24 S. arXiv:1104.4551.

- Besnard F. 2012. Is there a philosophy of time compatible with relativity and quantum mechanics? AIP Conference Proceedings 1446(1), 437–447. DOI: 10.1063/1.4728010.

- Blood C. 2009a. Quantum Mechanics and the Source of Awareness. FQXi Essay Contest 2009, 11 S.

- Blood C. 2009b. Problems with Probability in Everett's Interpretation of Quantum Mechanics. 8 S. arXiv:0901.0952.

- Boge F. 2016. On Probabilities in the Many Worlds Interpretation of Quantum Mechanics. Bachelor Thesis, University of Cologne, 50 S.

- Borde A., Guth A.H. & Vilenkin A. 2003. Inflationary Spacetimes Are Incomplete in Past Directions. Physical Review Letters 90(15):151301. DOI: 10.1103/PhysRevLett.90.151301, arXiv:gr-qc/0110012.

- Bostrom N. 1998. The Doomsday Argument: a Literature Review. Webseite.

- Bostrom N. 2001. Anthropic Bias: Observation Selection Effects in Science and Philosophy. Routledge, 240 S.

- Bostrom N. 2003. Are We Living in a Computer Simulation? The Philosophical Quarterly 53(211), 243–255. DOI: 10.1111/1467-9213.00309.

- Bowler P.J. 1978. Hugo De Vries and Thomas Hunt Morgan: The mutation theory and the spirit of Darwinism. Annals of Science 35(1), 55–73. DOI: 10.1080/00033797800200141.

- Branciard C. 2014. How ψ-epistemic models fail at explaining the indistinguishability of quantum states. Physical Review Letters 113, 020409, 1–5. DOI: 10.1103/PhysRevLett.113.020409, arXiv:1407.3005.

- Brooks M. 2020. Is the universe conscious? It seems impossible until you do the maths. NewScientist 29. April 2020.

- Brumfiel G. 2010. Scientists supersize quantum mechanics. Nature News 17. März 2010. DOI: 10.1038/news.2010.130.

- Bruza P.D., Wang Z. & Busemeyer J.R. 2015. Quantum cognition: a new theoretical approach to psychology. Trends in Cognitive Sciences 19(7), 383–393. DOI: 10.1016/j.tics.2015.05.001.

- Calosi C. 2017. Quantum monism: an assessment. Philosophical Studies 175, 3217–3236. DOI: 10.1007/s11098-017-1002-6.

- Campbell T. 2007. My Big TOE: The Complete Trilogy. Lightning Strike books, 824 S.

- Cao C., Carroll S. & Michalakis S. 2017. Space from Hilbert Space: Recovering geometry from bulk entanglement. Physical Review D 95(2):024031. DOI: 10.1103/PhysRevD.95.024031, arXiv:1606.08444.

- Carroll S. 2010. Against Space. Discover Magazine Nov. 10, 2010 (Presentation at SlideShare).

- Carroll S. 2014. Ten Questions for the Philosophy of Cosmology. Sean Carroll Blog 3. Oktober 2014.

- Carroll S. 2015. Does Spacetime Emerge From Quantum Information? Sean Carroll Blog 5. Mai 2015.

- Carroll S. 2016. Space Emerging from Quantum Mechanics. Sean Carroll Blog 18. Juli 2016.

- Carroll S. 2019a. Something Deeply Hidden: Quantum Worlds and the Emergence of Spacetime. Oneworld Publications, 368 S.

- Carroll S. 2019b. The Notorious Delayed-Choice Quantum Eraser. Sean Carroll Blog Sept. 21, 2019.

- Chaitin G. 2006. The Limits of Reason. Scientific American 294(3), 74–81. DOI: 10.1038/scientificamerican0306-74. [PDF]

- Chaitin G. 2008. Irreducible Complexity in Pure Mathematics. pp. 261-272 in: Hrachovec H. & Pichler A. (Hrsg.): Wittgenstein and the Philosophy of Information: Proceedings of the 30th International Ludwig Wittgenstein-Symposium in Kirchberg, 2007. De Gruyter. DOI: 10.1515/9783110328462.261.

- Chalmers D.J. 2019. Idealism and the Mind-Body Problem. in: Saeger W.E. (Hrsg.). The Routledge Handbook of Panpsychism. Oxford University Press, 396 S. DOI: 10.4324/9781315717708.

- Cocchi M. et al. 2017. Linoleic acid: Is this the key that unlocks the quantum brain? BMC Neuroscience18(1):38, 1–10. DOI: 10.1186/s12868-017-0356-1.

- Coles P.J., Kaniewski J. & Wehner S. 2014. Equivalence of wave–particle duality to entropic uncertainty. Nature Communications 5:5814, 1–8. DOI: 10.1038/ncomms6814, arXiv:1403.4687.

- Conn Henry R. 2005. The mental Universe. Nature 436, 29. DOI: 10.1038/436029a.

- Conway J. & Kochen S. 2006. The Free Will Theorem. Foundations of Physics 36, 1441–1473. DOI: 10.1007/s10701-006-9068-6, arXiv:quant-ph/0604079.

- Cowen R 2015. The quantum source of space-time. Nature 527(7578), 290–293. DOI: 10.1038/527290a.

- Crowther K. 2014. Appearing Out of Nowhere: The Emergence of Spacetime in Quantum Gravity. PhD thesis, University of Sidney, 290 S. arXiv:1410.0345.

- Cundy N. 2019. The A and B Theories of Time. The Quantum Thomist 21. Juli 2019.

- Dawid R. & Thébault K. 2015. Many worlds: decoherent or incoherent? Synthese 192, 1559–1580. DOI: 10.1007/s11229-014-0650-8.

- D’Arcy Thompson (1917, 1940). On Growth and Form. Cambridge University Press, 793 S. (1. Aufl. 1917) bzw. 1116 S. (erw. 2. Aufl. 1940).

- Davies P. 2019. The Demon in the Machine: How Hidden Webs of Information Are Solving the Mystery of Life. University of Chicago Press, 272 S.

- Davies P. & Gregersen N.H. 2014. Information and the Nature of Reality: From Physics To Metaphysics. Cambridge University Press, 506 S.

- Deutsch D. & Marletto C. 2014. Why we need to reconstruct the universe". The New Scientist 222(2970), 30–31. (online as "Reconstructing physics: The universe is information")

- Doran C.F., Faux M.G., Gates S.J., Hubsch T., Iga K.M. & Landweber G.D. 2008. Relating Doubly-Even Error-Correcting Codes, Graphs, and Irreducible Representations of N-Extended Supersymmetry. 19 S. arXiv:0806.0051.

- Dorato M. 2015a. Laws of nature and the reality of the wave function. Synthese 192, 3179–3201. DOI: 10.1007/s11229-015-0696-2, arXiv:1503.01137.

- Dorato M. 2015b. Presentism and the Experience of Time. Topoi 34(1), 265–275. [PDF]

- Dressel J. & Korotkov A.N. 2014. Avoiding Loopholes with Hybrid Bell-Leggett-Garg Inequalities. Physical Review A 89:012125, 1–5. DOI: 10.1103/PhysRevA.89.012125, arXiv:1310.6947.

- Driessen A. & Suarez A. (Hrsg.) 1997. Mathematical Undecidability, Quantum Nonlocality and the Question of the Existence of God. Springer / Kluwer, 242 S. [PDF]

- Dyke H. 2002. Review of The Tensed Theory of Time, by W. L. Craig. Dordrecht: Kluwer Academic Publishers, 2000. International Philosophical Quarterly 42, 404–406. [PDF]

- Dyson F. 1988. Infinite in all Directions. Harper & Row, 329 S.

- Edwards J. 1957. The Works of Jonathan Edwards. Herausgegeben von Perry Miller (Bde 1–2), John E. Smith (Bde 3–9) und Harry S. Stout (Bde 10–26). Yale University Press.

- Eichman P. 2007. Relativistic Challenges to Presentism. 18 S. Dissertation. [PDF]

- Einstein A., Poldolsky B. & Rosen N. 1935. Can quantum-mechanical description of physical reality be considered complete? Physical Review 47, 777–780. DOI: 10.1103/PhysRev.47.777.

- Ellerman D. 2012. A Common Fallacy in Quantum Mechanics: Why Delayed Choice Experiments do NOT imply Retrocausality. Quantum Studies: Mathematics and Foundations 2, 183–199. DOI: 10.1007/s40509-014-0026-2, arXiv:1112.4522.

- Elsheik E.M. 2016. Evolution physical intelligent guiding principle. Energy, Ecology and Environment 1(2), 75–85. DOI: 10.1007/s40974-016-0010-2.

- El-Showk S. & Papadodimas K. 2012. Emergent Spacetime and Holographic CFTs. Journal of High Energy Physics 2012(10), 106. DOI: 10.1007/JHEP10(2012)106, arXiv:1101.4163.

- Everett H. III 1956. The Theory of the Universal Wave Function. Dissertation, 140 S.

- Everett H. III 1957. "Relative state" formulation of quantum mechanics. Reviews of Modern Physics 29(3), 454–462. DOI: 10.1103/RevModPhys.29.454.

- Faber J., Portugal R. & Pinguelli Rosa L. 2006. Information Processing in Brain Microtubules. Biosystems 83(1), 1–9. DOI: 10.1016/j.biosystems.2005.06.011, arXiv:q-bio/0404007v2.

- Fein Y.Y. et al. 2019. Quantum superposition of molecules beyond 25 kDa. Nature Physics 15, 1242–1245. DOI: 10.1038/s41567-019-0663-9.

- Feldmann M. 2020. Information-theoretic interpretation of quantum formalism. 86 S. arXiv:1312.7551.

- Feldmann M. 2020b. ”It from bit” and ”Law without law”: The route of information theory towards the refoundation of physics. 55 S. hal-02471910.

- Fields C., Hoffman D.D., Prakash, C. & Singh M. 2017. Conscious agent networks: Formal analysis and application to cognition. Cognitive Systems Research 47, 186–213. DOI: 10.1016/j.cogsys.2017.10.003.

- Frauchinger D. & Renner R. 2018. Quantum theory cannot consistently describe the use of itself. Nature Communications 9: 3711, 1–10. DOI: 10.1038/s41467-018-05739-8.

- Fuchs C.A. 2017. On Participatory Realism. S. 113-134 in: Durham I. & Rickles D. (Hrsg.): Information and Interaction. The Frontiers Collection. Springer, Cham. DOI: 10.1007/978-3-319-43760-6_7; arXiv:1601.04360.

- Fuwa, M., Takeda, S., Zwierz, M., Wiseman H.M. & Furusawa A. 2015. Experimental proof of nonlocal wavefunction collapse for a single particle using homodyne measurements. Nature Communications 6, 6665, 1–6. DOI: 10.1038/ncomms7665.

- Gachechiladze M. et al. 2016. Extreme violation of local realism in quantum hypergraph states. Physical Review Letters 116(7):070401. DOI: 10.1103/PhysRevLett.116.070401, arXiv:1507.03570.

- Galvan B. 2010. On the preferred-basis problem and its possible solutions. 16 S. arXiv:1008.3708v1.

- Gao S. 2018. A simple proof that the many-worlds interpretation of quantum mechanics is inconsistent. Preprint http://philsci-archive.pitt.edu/15498/.

- Gates J. 2010. Symbols of power. Physics World 23(6), 34–39 (PDF).

- Gerig A. 2012. The Doomsday Argument in Many Worlds. 18 S. arXiv:1209.6251.

- Gerig A., Olum K.D. & Vilenkin A. 2013. Universal Doomsday: Analyzing Our Prospects for Survival. Journal of Cosmology and Astroparticle Physics 2013(05):013, 1–13. DOI: 10.1088/1475-7516/2013/05/013, arXiv:1303.4676.

- Gerlich S. et a. 2011. Quantum interference of large organic molecules. Nature Communications 2, 263, 1–5. DOI: 10.1038/ncomms1263.

- Glattfelder J.B. 2019. A Universe Built of Information. S. 473–514 in: Glattfelder J.B. Information—Consciousness—Reality. Springer Open. DOI: 10.1007/978-3-030-03633-1_13. [PDF]

- Goff P. 2017. Consciousness and Fundamental Reality. Oxford University Press, 304 S.

- Goff P. 2019a. Did the universe design itself? International Journal for Philosophy of Religion 85(1), 99–122. DOI: 10.1007/s11153-018-9692-z.

- Goff P. 2019b. Cosmopsychism, Micropsychism and the Grounding Relation. 13 S. in: Saeger W.E. (Hrsg.). The Routledge Handbook of Panpsychism. Routledge, 396 S. DOI: 10.4324/9781315717708. [PDF]

- Goldschmidt R. 1940. The Material Basis of Evolution. Yale University Press, 436 S.

- Gordon B.L. 2017. Divine Action and the World of Science: What Cosmology and Quantum Physics Teach Us about the Role of Providence in Nature. JBTS 2(2), 247–298 (PDF).

- Goswami A. 1989. The Idealistic Interpretation of Quantum Mechanics. Physics Essays 2(4), 385–400. DOI: 10.4006/1.3035899. (Also available here)

- Goswami A. 1993. The Self-Aware Universe: How Consciousness Creates the Material World. TarcherPerigee, 336 S.

- Goswami, A. 1995. Monistic idealism may provide better ontology for cognitive science: A reply to Dyer. Journal of Mind and Behavior 16(2), 135–150. JSTOR:43853677.

- Goswami A. 2001. The Physicists’ View of Nature Part 2: The Quantum Revolution. Spinger, 329 S.

- Goswami A. 2008. Creative Evolution: A Physicist's Resolution Between Darwinism and Intelligent Design. Quest Books, 344 S.

- Gould S.J. 1977. The Return of Hopeful Monsters. Natural History 86(6), 24–30. [PDF]

- Greene B. 2014. What is the Holographic Principle? World ScienceU YouTube-Kanal.

- Griffin D.R. 2008. Whitehead’s Naturalism and a Non-Darwinian View of Evolution. In: Cobb J.B. (Hrsg.). Back to Darwin: A Richer Account of Evolution. W.B. Eerdmans Pub. Co., 434 S.

- Griffin D.R. 2012. Whitehead's Radically Different Postmodern Philosophy: An Argument for Its Contemporary Relevance. SUNY Press, 315 S. (Seite 143). [Google Books]

- Gröblacher S. et al. 2007. An experimental test of non-local realism. Nature 446, 871–875. DOI: 10.1038/nature05677, arXiv:0704.2529.

- Gruber R.P. & Block R.A. 2013. The Flow of Time as a Perceptual Illusion. The Journal of Mind and Behavior 34(1), 91–100. JSTOR:43854468.

- Gruber R.P., Smith R.P. & Block R.A. 2018. The Illusory Flow and Passage of Time within Consciousness: A Multidisciplinary Analysis. Timing & Time Perception 6(2), 125–153. DOI: 10.1163/22134468-2018e001.

- Gupta U. 2018. Emergent Spacetime. (Internet Archive)

- Hameroff S. 2017. Chapter 20 - The Quantum Origin of Life: How the Brain Evolved to Feel Good. S. 333-353 in: Tibayrenc M. & Ayala F.J. (Hrsg.). On Human Nature. Academic Press, 814 S. DOI: 10.1016/B978-0-12-420190-3.00020-X.

- Hameroff S. & Penrose R. 2014. Consciousness in the universe: A review of the ‘Orch OR’ theory. Physics of Life Reviews 11(1), 39–78. DOI: 10.1016/j.plrev.2013.08.002.

- Haynes E. 2016. A Case for Monistic Idealism: Connecting Idealistic Thoughts from Leibniz to Kant with support in Quantum Physics. Thesis Liberty University Graduate School, 95 S.

- Heinrich S.B. 2012. The Relativity of Existence. 13 S. arXiv:1202.4545.

- Hettema J.D. 2015. Quantum Mechanics as a Case for Edwardsian Idealism. 19 S.

- Hoel E.P., Albantakis L., Marshall W. & Tononi G. 2016. Can the macro beat the micro? Integrated information across spatiotemporal scales. Neuroscience of Consciousness 1, niw012, 1–13. DOI: 10.1093/nc/niw012.

- Hoffman D.D. 2008. Conscious Realism and the Mind-Body Problem. Mind & Matter 6(1), pp. 87–121.

- Hoffman D.D. 2014. The Origin of Time in Conscious Agents. Cosmology 18, 494–520. [PDF]

- Hoffman D. 2019. The Case Against Reality: Why Evolution Hid the Truth from Our Eyes. Norton & Co., 272 S.

- Hoffman D.D. & Prakash C. 2014. Objects of consciousness. Frontiers in Psychology, 5:577, 1–22. DOI: 10.3389/fpsyg.2014.00577.

- Hoffman D.D., Singh M. & Prakash C. 2015. Probing the interface theory of perception: Reply to commentaries. Psychonomic Bulletin & Review 22, 1551–1576. DOI: 10.3758/s13423-015-0931-3.

- Horowitz G.T. 2005. Spacetime in String Theory. New Journal of Physics 7:201, 1–13. DOI: 10.1088/1367-2630/7/1/201, arXiv:gr-qc/0410049.

- Hossenfelder S. 2019. The Trouble with Many Worlds. BackReaction 27. Sept. 2019.

- Huang H.-L. et al. 2019. Compatibility of causal hidden-variable theories with a delayed-choice experiment. Physycal Review A 100:012114, 1–7. DOI: 10.1103/PhysRevA.100.012114, arXiv:1806.00156.

- Huggett N. & Wüthrich C. 2017. The (A)temporal Emergence of Spacetime. Philosophy of Science 85(5), 1190–1203. DOI: 10.1086/699723.

- Huggett N., Matsubara K. & Wüthrich C. (Hrsg.) 2020. Beyond Spacetime: The Foundations of Quantum Gravity. Cambridge University Press, 370 S.

- Hutto D. 2000. Beyond Physicalism. John Benjamins Pub. Co., 266 S.

- Irwin K., Amaral M. & Chester D. 2020. The Self-Simulation Hypothesis Interpretation of Quantum Mechanics. Entropy 2020, 22(2), 247, 1–26. DOI: 10.3390/e22020247.

- Ismael J. & Schaffer J. 2016. Quantum holism: nonseparability as common ground. Synthese 2016, 1–30. DOI: 10.1007/s11229-016-1201-2.

- Jacobson T. 1995. Thermodynamics of Spacetime: The Einstein Equation of State. Physics Review Letters 75, 1260–1263. DOI: 10.1103/PhysRevLett.75.1260, arXiv:gr-qc/9504004.

- Jaskolla L.J. & Buck A.J. 2012. Does Panexperiential Holism Solve the Combination Problem? Journal of Consciousness Studies 19(9-10), 190–199.

- Jacques V. et al. 2007. Experimental Realization of Wheeler's Delayed-Choice Gedanken Experiment. Science 315(5814), 966–968. DOI: 10.1126/science.1136303.

- Ji Z., Natarajan A., Vidick T., Wright J. & Yuen H. 2020. MIP*=RE. 165 S. arXiv:2001.04383.

- John E.R. 2002. The neurophysics of consciousness. Brain Research Reviews 39(1), 1–28. DOI: 10.1016/S0165-0173(02)00142-X.

- Jones M. 2013. The Case for Free Will. Inspiring Philosophy YouTube-Kanal

- Jones M. 2014a. A Critique of the Many Worlds Interpretation. Inspiring Philosophy YouTube-Kanal.

- Jones M. 2014b. Christianity and Panentheism. Inspiring Philosophy YouTube-Kanal.

- Jordan S. 2016. Amazing Discovery: Hermeticism explained by cutting edge physics breakthrough. thespiritscience.net 7. September 2016.

- Kastrup B. 2012. My philosophy and Sheldrake's morphic fields. Metaphysical Speculations Blog 18. März 2012.

- Kastrup B. 2015. The Reality Nervous System. Metaphysical Speculations Blog 12. April 2015.

- Kastrup B. 2019a. Analytic Idealism: A consciousness-only ontology. Dissertation, Radbound Universität Nijmegen.

- Kastrup B. 2019b. The Idea of the World: A Multi-Disciplinary Argument for the Mental Nature of Reality. John Hunt Publ., 312 S.

- Kastrup B. 2019c. Evolution is true, but are mutations really random? Metaphysical Speculations Blog 8. August 2019.

- Kehler C. 2011. Time for a Change: A refutation of presentism. Master Thesis, University of Manitoba, 71 S. [PDF]

- Kersgaard E. 2019. Critiques of the Many Worlds (Multiverse) Interpretation of Quantum Mechanics. Medium 17. November 2019.

- Kim Y.H. et al. 2000. A Delayed Choice Quantum Eraser. Physical Review Letters 84, 1–5. DOI: 10.1103/PhysRevLett.84.1; arXiv:quant-ph/9903047.

- Kleiner J. & Tull S. 2020. The Mathematical Structure of Integrated Information Theory. 22 S. arXiv:2002.07655.

- Klimov P.V. et al. 2015. Quantum entanglement at ambient conditions in a macroscopic solid-state spin ensemble. Science Advances 1(10), e1501015, 1–7. DOI: 10.1126/sciadv.1501015.

- Klyachko A.A., Ali Can M., Binicioğlu S. & Shumovsky A.S. 2008. Simple Test for Hidden Variables in Spin-1 Systems. Physical Review Letters 101, 020403. DOI: 10.1103/PhysRevLett.101.020403.

- Kochen S. & Specker E.P. 1967. The Problem of Hidden Variables in Quantum Mechanics. Journal of Mathematics and Mechanics 17, 59–87. DOI: 10.1512/iumj.1968.17.17004.

- Kölliker A.v. 1864. Ueber die Darwinsche Schöpfungstheorie. Zeitschrift für wissenschaftliche Zoologie 14, 174–186.

- Kofler J. & Brukner C. 2008. The conditions for quantum violation of macroscopic realism. Physical Review Letters 101:090403. DOI: 10.1103/PhysRevLett.101.090403, arXiv:0706.0668.

- Krioukov, D., Kitsak, M., Sinkovits, R.S., Rideout D., Meyer D. & Boguñá M. 2012. Network Cosmology. Scientific Reports 2, 793, 1–6. DOI: 10.1038/srep00793.

- Kryukov A.A. 2004. On the Problem of Emergence of Classical Space—Time: The Quantum-Mechanical Approach. Foundations of Physics 34(8), 1225–1248. DOI: 10.1023/B:FOOP.0000041290.67197.a7.

- Kurzweil R. 1999. The Age of Spiritual Machines: When Computers Exceed Human Intelligence. Viking, New York.

- Lamme V.A. 2010. How neuroscience will change our view on consciousness. Cognitive Neuroscience 1(3), 204–240. DOI: 10.1080/17588921003731586.

- Lane A. 2011. The flawed multiverse. physicsworld 22. September 2011.

- Lanza R. 2009. Biocentrism: How Life and Consciousness Are the Keys to Understanding the True Nature of the Universe. BenBella, 224 S.

- Lapkiewicz R. et al. 2011. Experimental non-classicality of an indivisible quantum system. Nature 474, 490–493. DOI: 10.1038/nature10119, arXiv:1106.4481.

- Lee S.-S. 2019. A model of quantum gravity with emergent spacetime. 72 S. arXiv:1912.12291.

- Leifer M.S. & Pusey M.F. 2017. Is a time symmetric interpretation of quantum theory possible without retrocausality? Proceedings of the Royal Society A 473: 20160607, 1–24. DOI: 10.1098/rspa.2016.0607.

- Leslie J. 2001. Infinite Minds: A Philosophical Cosmology. Clarendon Pr., 248 S.

- Leslie J. 2008. Infinitely Long Afterlives and the Doomsday Argument. Philosophy 83(4), 519–524. DOI: 10.1017/S0031819108000867.

- Li J. 2013. A Timeless and Spaceless Quantum Theory of Consciousness. NeuroQuantology 11(3), 431–442. DOI: 10.14704/nq.2013.11.3.684.

- Licata I. 2016. Beyond Peaceful Coexistence; The Emergence Of Space, Time and Quantum. Imperial College Press, 740 S.

- Lin J., Marcolli M., Ooguri H. & Stoica B. 2015. Locality of Gravitational Systems from Entanglement of Conformal Field Theories. Physical Review Letters 114(22), 221601, 1–5. DOI: 10.1103/PhysRevLett.114.221601.

- Lloyd S. 2006. Programming the Universe. A Quantum Computer Scientist Takes on the Cosmos. Jonathan Cape, 240 S.

- Lloyd S. 2013. The universe as a quantum computer. In Zenil H. (Hrsg.). A Computable Universe: Understanding and exploring Nature as computation. World Scientific, Singapore. arXiv:1312.4455.

- Lokanga E. 2018. Digital Physics: The Meaning of the Holographic Universe and Its Implications Beyond Theoretical Physics. CreateSpace, 178 S.

- Ma X-s. et al. 2012. Experimental delayed-choice entanglement swapping. Nature Physics 8, 479–484. DOI: 10.1038/nphys2294.

- Ma X-s. et al. 2013. Quantum erasure with causally disconnected choice. PNAS 110(4), 1221–1226. DOI: 10.1073/pnas.1213201110, arXiv:1206.6578.

- Ma X-s. 2016. Delayed-choice gedanken experiments and their realizations. Reviews of Modern Physics88:015005. DOI: 10.1103/RevModPhys.88.015005, arXiv:1407.2930.

- Maldacena J.M. 1999. The Large N Limit of Superconformal Field Theories and Supergravity. International Journal of Theoretical Physics 38, 1113–1133. DOI: 10.1023/A:1026654312961, arXiv:hep-th/9711200.

- Maldacena J. 2007. Comments on emergent space-time. S. 195-198 in: Gross D. et al. The Quantum Structure of Space and Time: Proceedings of the 23rd Solvay Conference on Physics. Brussels, Belgium. 1 - 3 December 2005. 272 S.

- Maldacena J. & Susskind L. 2013. Cool horizons for entangled black holes. Progress of Physics 61(9), 781–811. DOI: 10.1002/prop.201300020, arXiv:1306.0533.

- Manning A.G., Khakimov R.I., Dall R.G. & Truscott A.G. 2015. Wheeler's delayed-choice gedanken experiment with a single atom. Nature Physics 11, 539–542. DOI: 10.1038/nphys3343.

- Manzano D. 2015. Measuring the reality of the wavefunction. mappingignorance 1. Juli 2015.

- Markopoulou F. 2009. Space does not exist, so time can. 9 S. arXiv:0909.1861.

- Martens N.C.M. 2019. The metaphysics of emergent spacetime theories. Philosophy Compass 14(7), e12596. DOI: 10.1111/phc3.12596.

- Mashkevich V.S. 2010. The Principle of Sufficient Reason and Quantum Determinism. 9 S. arXiv:1012.3222.

- McBrayer J.P. & Owen D. 2016. What Quantum Mechanics Doesn't Show. Teaching Philosophy 39:2, 163–176. DOI: 10.5840/teachphil201651648.

- McFadden J. 2002. Quantum Evolution: How Physics' Weirdest Theory Explains Life's Biggest Mystery. Norton & Co., 352 S.

- McFadden J. 2020. Integrating information in the brain’s EM field: the cemi field theory of consciousness. Neuroscience of Consciousness 2020(1), niaa016, 1–13. DOI: 10.1093/nc/niaa016.

- McFadden J.J. & Al-Khalili J.V. 1999. A quantum mechanical model of adaptive mutation. Biosystems 50(3), 203–211. DOI: 10.1016/s0303-2647(99)00004-0.

- McFadden J.J. & Al-Khalili J.V. 2001. Comment on Book Review of 'Quantum Evolution' (Johnjoe McFadden) by Mathew J. Donald. 5 S. arXiv:quant-ph/0110083.

- McGrew L. 2014. How do I rebut Presentism? Let me count the ways. Blog Extra Thoughts 12. April 2014.

- Meijer D.K.F. & Raggett S. 2014. Quantum Physics in Consciousness Studies. In Raggett S. (Hrsg.). Quantum Physics in Consciousness Studies. The Quantum Mind Extended. Quantum Mind UK, 177 S. [ResearchGate]

- Merali Z. 2014. Solving Biology's Mysteries Using Quantum Mechanics. Discover Magazine 29. Dezember 2014.

- Miller K. & Loo J.W. 2016. Presentism, Passage, Phenomenology and Physicalism. Manuscrito – Rev. Int. Fil. Campinas 39(4), 183–201. DOI: 10.1590/0100-6045.2016.v39n4.kj.

- Mohanty J.N. 1989. Idealism an the Quantum Mechanics. History of Philosophy Quarterly 6(4), 381–391. JSTOR: 27743911.

- Monton B. 2000. On Dualistic Interpretations of Quantum Mechanics. Preprint http://philsci-archive.pitt.edu/2913/.

- Monton B. 2009. McTaggart and modern physics. Philosophia 38(2): 257–264. http://philsci-archive.pitt.edu/4615/.

- Moreva E. et al. 2014. Time from quantum entanglement: An experimental illustration. Physical Review A 89:052122. DOI: 10.1103/PhysRevA.89.052122, arXiv:1310.4691.

- Morita K. 2017. Presentism and the Multiverse Hypothesis. Annals of the Japan Association for Philosophy of Science 26, 1–8. DOI: 10.4288/jafpos.26.0_1.

- Moskovitz C. 2016. Tangled Up in Spacetime. Scientific American 26. Oktober 2016.

- Motl L. 2015. All realistic "interpretations" falsfied by low heat capacities. the reference frame 14. Mai 2015.

- Motl L. 2019. Basic letal flaws of revisionist "interpretations" of QM. the reference frame 19. August 2019.

- Müller G.B. 2017. Why an extended evolutionary synthesis is necessary. Interface Focus 7(5): 20170015, 1–11. DOI: 10.1098/rsfs.2017.0015.

- Musser G. 2017. A Theory of Consciousness Can Help Build a Theory of Everything. Nautilus 4. Mai 2017.

- Musser G. 2018. What is Spacetime? Nature 557, S3–S6. DOI: 10.1038/d41586-018-05095-z. Scientific American 318(6), 55–58. DOI: 10.1038/scientificamerican0618-55.

- Nagasawa Y. & Wagner K. 2016. Panpsychism and Priority Cosmopsychism. S. 113–129 in: Brüntrup G. & Jaskolla L. (Hrsg.). Panpsychism: Contemporary Perspectives. Oxford University Press, 424 S. DOI: 10.1093/acprof:oso/9780199359943.003.0005.

- Nagel T. 2012. Mind and Cosmos: Why the Materialist Neo-Darwinian Conception of Nature is Almost Certainly False. Oxford University Press, 144 S.

- Nemer G., Bergqvist C. & Kurban M. 2017. Darwinian Evolution and Quantum Evolution are Complementary: A Perspective. Hereditary Genetics 6(2):100081, 1–4. DOI: 10.4172/2161-1041.1000181.

- Neumann J.v. 1955. Mathematical Foundations of Quantum Mechanics. Princeton University Press, 328 S. (neue Ausg. 2018).

- Nomura Y, Rath P. & Salzetta N. 2018. Spacetime from Unentanglement. 51 S. arXiv:1711.05263.

- Noorbala M. 2018. SpaceTime from Hilbert Space: Decompositions of Hilbert Space as Instances of Time. Fortschritte der Physik / Progress of Physics 66(2), 1800002. DOI: 10.1002/prop.201800002.

- NOVA 2015. Are the Quantum World and The Real World the Same Thing? NOVA 7. Mai 2015.

- Ockeloen-Korppi C.F. et al. 2018. Stabilized entanglement of massive mechanical oscillators. Nature 556, 478–482. DOI: 10.1038/s41586-018-0038-x.

- Ogryzko V. 2009. On two quantum approaches to adaptive mutations in bacteria. NeuroQuantology 7(4), 564–595. DOI: 10.14704/nq.2009.7.4.253, arXiv:0805.4316.

- Oizumi M., Albantakis L. & Tononi, J. 2014. From the Phenomenology to the Mechanisms of Consciousness: Integrated Information Theory 3.0. PLOS Computational Biology 10(5), e1003588. DOI: 10.1371/journal.pcbi.1003588.

- Okon E. & Sebastián M.A. 2018. A consciousness-based quantum objective collapse model. Synthese 2018, 1–21. DOI: 10.1007/s11229-018-1887-4.

- Padmanabhan T. 2014. Gravity and Spacetime: An Emergent Perspective. S. 213-242 in: Ashtekar A. & Petkov V. (Hrsg.): Springer Handbook of Spacetime. Springer, xxv+847 S. DOI: 10.1007/978-3-642-41992-8_12.

- Päs H. 2019. Quantum Monism Could Save the Soul of Physics. Scientific American Blog March 5, 2019.

- Page D.N. 2008. Scientific and Philosophical Challenges to Theism. Chapter 30 in Stewart M.Y. (Hrsg.): Science and Religion in Dialogue. Blackwell Publ. DOI: 10.1002/9781444317350.ch30, arXiv:0801.0247.

- Paksi D. 2012. In Defense of Polanyi’s Understanding of Evolution: A Response to Walter Gulick. Tradition and Discovery 38(2), 48–55 (PDF).

- Palmer E. & Palmer O. 2018. Quantum Hermetica. 103 S.

- Parfit D. 1971. Personal Identity. The Philosophical Review 80(1), 3–27. JSTOR:2184309.

- Parfit D. 1984. Reasons and Persons. Oxford University Press, 560 S.

- Parrochia D. 2020. Are there really many worlds in the "Many-worlds interpretation" of Quantum Mechanics? 33 S. arXiv:2001.03771.

- Pearce D. 2017. Non-Materialist Physicalism: An experimentally testable conjecture. https://www.physicalism.com.

- Petkov V. 2006. Chapter 11: Is There an Alternative to the Block Universe View. S. 207–228 in: Dieks D. (Hrsg.). The Ontology of Spacetime. Philosophy and Foundations of Physics Vol. 1. Elsevier Science, 306 S. DOI: 10.1016/S1871-1774(06)01011-4.

- Petkov V. 2007. Chapter 7: Relativity, Dimensionality, and Existence. S. 115–135 in: Petkov V. (Hrsg.). Relativity and the Dimensionality of the World. Fundamental Theories of Physics Vol. 153. Springer 293 S. DOI: 10.1007/978-1-4020-6318-3_7.

- Popov M.A. 2003. In defence of quantum idealism. Physics-Uspekhi 46(12), 1307. DOI: 10.1070/PU2003v046n12ABEH001642 (PDF).

- Poulston G. 2015. Can We Defend the Notion of the Present? 15 S. Academia.edu.

- Proietti M. et al. 2019. Experimental rejection of observer-independence in the quantum world. Science Advances 5(9):eaaw9832. DOI: 10.1126/sciadv.aaw9832, arXiv:1902.05080.

- Pusey M.F., Barrett J. & Rudolph T., 2012. On the reality of the quantum state. Nature Physics 8, 475–478. DOI: 10.1038/nphys2309, arXiv:1111.3328.

- Qi X-L. 2018. Does gravity come from quantum information? Nature Physics 14, 984–987. DOI: 10.1038/s41567-018-0297-3.

- Quellette J. 2015. How Quantum Pairs Stitch Space-Time. QuantaMagazine 28. April 2015.

- Raatz J. 2013. How God Exists. Johanan Raatz YouTube-Kanal 8.6.2013.

- Raatz J. 2016. The Physics of Miracles. Johanan Raatz YouTube-Kanal 12.9.2016.

- Raatz J. 2017. The Integrated Triad. Johanan Raatz YouTube-Kanal 27.3.2017.

- Raatz J. 2020. Could Autonomous Agents Lie Beneath Emergent Spacetime. Johanan Raatz YouTube-Kanal 4.1.2020.

- Reason C. 2017. Comment on the paper Quantum mechanics needs no consciousness by Yu and Nikolic (2011). arXiv:1707.01346.

- Rieper E. et al. 2010. Quantum entanglement between the electron clouds of nucleic acids in DNA. 7 S. arXiv:1006.4053.

- Rieppel O. 2001. Turtles as Hopeful Monsters. Bioessays 23(11), 987–991. DOI: 10.1002/bies.1143.

- Rieppel O. 2017. Turtles as Hopeful Monsters: Origins and Evolution. Indiana University Press, Bloomington, 212 S.

- Ringbauer M. 2017. On the Reality of the Wavefunction. S. 85–136 in: Ringbauer M. Exploring Quantum Foundations with Single Photons. Spinger Theses (Recognizing Outstanding Ph.D. Research). Springer, Cham, 208 S. DOI: 10.1007/978-3-319-64988-7_4.

- Ringbauer M., Duffus B., Branciard C., Cavalcanti E.G., White A.G. & Fedrizzi A. 2015. Measurements on the reality of the wavefunction. Nature Physics 11, 249–254. DOI: 10.1038/nphys3233, arXiv:1412.6213.

- Romero G.E. 2014 (Online 2014, dedruckt 2015)). Present Time. Foundations of Science 20, 135–145. DOI: 10.1007/s10699-014-9356-0.

- Romero G.E. 2015 (Online 2015, gedruckt 2017). On the Ontology of Spacetime: Substantivalism, Relationism, Eternalism, and Emergence. Foundations of Science 22(1), 141–159. DOI: 10.1007/s10699-015-9476-1.

- Romero G.E. 2017. Space, Time and Irreversibility - The Philosophical Problems of Contemporary Astrophysics. Mètode Science Studies Journal 7, 201–209. DOI: 10.7203/metode.7.8478. [PDF]

- Romero G.E. & Pérez D. 2014. Presentism Meets Black Holes. European Journal for Philosophy of Science 4(3), 293–308. DOI: 10.1007/s13194-014-0085-6.

- Rorvig M. 2020. Mathematicians Are Studying Planet-Sized Quantum Computers With God-Like Powers. Vice 11. Februar 2020.

- Rosenblum B. & Kuttner F. 2006. Quantum Enigma. Oxford University Press, 211 S.

- Rovelli C. 1996. Relational Quantum Mechanics. International Journal of Theoretical Physics 35, 1637–1678. DOI: 10.1007/BF02302261, arXiv:quant-ph/9609002.

- Rucker R. 2008. Fundamental Limits to Virtual Reality. Rudy's Blog

- Rucker R. 2012. The Great Awakening. In: Collected Essays. Transreal Books, 659 S.